Esquema

-

El maniquí de máquina de pensamiento continuo (CTM) incorpora el tiempo en las redes neuronales para la resolución de problemas más humano.

-

CTMS obturación la brecha entre los modelos de educación de IA como LLM y la adaptabilidad de tipo humano, pero requieren más posibles.

-

El maniquí CTM enfrenta desafíos como tiempos de entrenamiento más largos, inferencia más lenta y último precisión en comparación con los modelos actuales.

¿Los modelos AI “piensan”? Esta es una pregunta importante, porque para algún que usa poco como Chatgpt o Claude, es seguro aspecto Como si el bot estuviera pensando. Incluso tenemos pocas indicaciones que aparecen que dicen “pensar” y en estos días incluso puedes observar la “sujeción de pensamiento” de un bot para ver cómo razonó su camino para una conclusión.

La verdad, sin bloqueo, es que, si aceptablemente los LLM y otros modelos de IA imitan ciertos aspectos del pensamiento, todavía no es lo mismo que un cerebro natural que hace el trabajo. Sin bloqueo, una nueva investigación sobre Máquinas de pensamiento continuas (CTMS) podría cambiar eso.

¿Qué es un CTM?

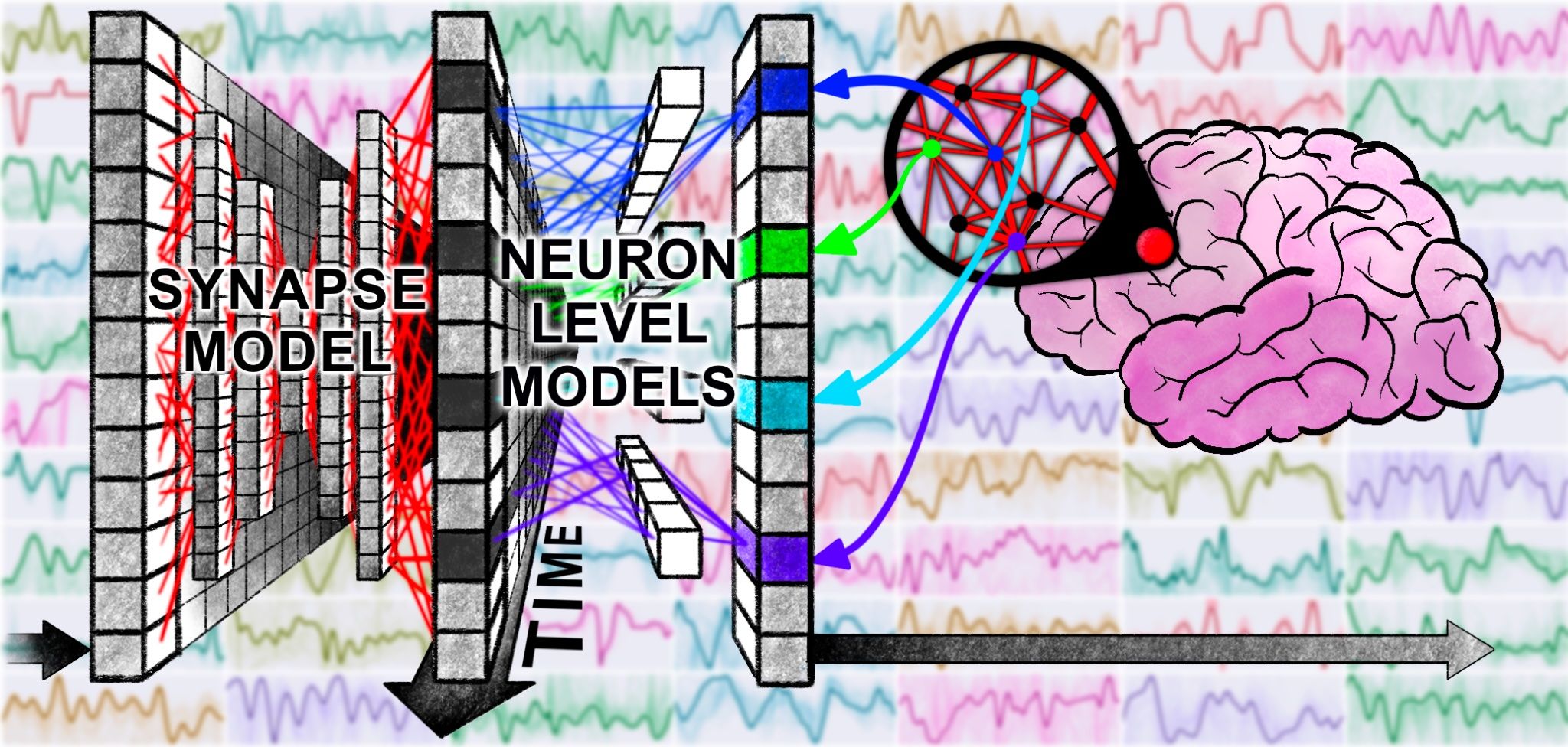

Una máquina de pensamiento continuo (CTM) es un nuevo tipo de red neuronal que textualmente incorpora el tiempo en su pensamiento. En circunscripción del cálculo habitual de un disparo, cada neurona CTM realiza un seguimiento de su actividad pasada y usa esa historia para lanzarse qué hacer a continuación. En mayo de 2025, Sakana Ai detalló el maniquí CTM en un trabajo de investigación y un publicación de blog.

Sakana afirma que este es un nuevo tipo de red neuronal químico que imita más de cerca cómo funcionan los cerebros naturales. Las neuronas en un CTM no solo disparan una vez y están hechas; Tienen una “memoria” corta y pueden sincronizar sus patrones de disparo con otras neuronas. El estado interno de la red se define por estos patrones de sincronía con el tiempo.

Eso se parece mucho a la sincronicidad en cerebros biológicos que conduce a las ondas cerebrales. Esto hace que CTMS sea muy diferente de las redes o transformadores profundos unificado. Por ejemplo, un maniquí característico basado en transformador procesa una estancia de texto (o una imagen) en un número fijo de capas, todo a la vez. Básicamente, piensa en una breve ataque definida, y luego se muere con cerebro mientras calma su próximo aviso.

Relacionado

AI está aquí para quedarse, así que actualice con estos 7 términos de IA

Sepa lo que significan los niños geniales con “LLM”.

Las implicaciones aquí son profundas. Si incluso entiendo lo que significa poco de esto, ¡y es muy posible que no! Esta cita de la publicación con respecto a la resolución de laberintos y mirando las fotos verdaderamente me llamó la atención:

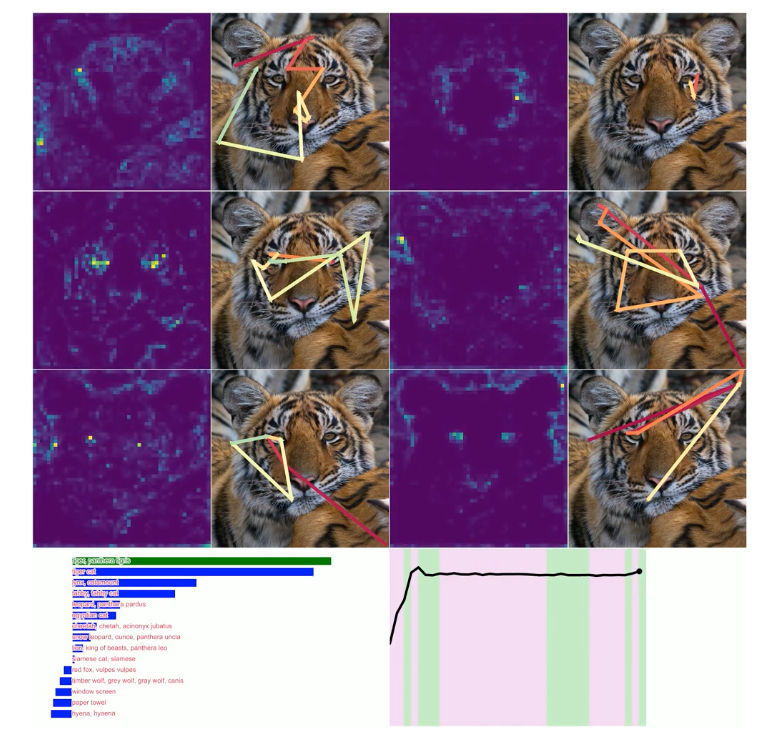

Sorprendentemente, a pesar de no ser diseñado explícitamente para hacerlo, la decisión que aprende en los laberintos es muy interpretable y humano, donde podemos ver que traza el camino a través del jaleo mientras ‘piensa’ sobre la decisión. Para imágenes reales, no hay un incentivo visible para mirar a su más o menos, pero lo hace de modo intuitiva.

Encima, esto lo resume asaz aceptablemente:

Llamamos al maniquí de IA resultante la máquina de pensamiento continuo (CTM), un maniquí capaz de usar esta nueva dimensión de tiempo, dinámica de neuronas ricas e información de sincronización para ‘pensar’ sobre una tarea y plan antiguamente de dar sus respuestas. Usamos el término ‘continuo’ en el nombre porque el CTM funciona completamente en una ‘dimensión de pensamiento’ interna al razonar. Es asincrónico con respecto a los datos que consume: puede razonar sobre datos estáticos (p. Ej., Imágenes) o datos secuenciales de modo idéntica. Probamos este nuevo maniquí en una amplia grado de tareas y descubrimos que es capaz de resolver diversos problemas y, a menudo, de una modo muy interpretable.

No quiero exagerar esta idea hasta que veamos más e independientes fiestas que la comparan, pero parte de lo que estoy leyendo aquí se extiende muy levemente en el reino de la conciencia rudimentaria.

Relacionado

¿Cuál es la diferencia entre AI musculoso y IA débil?

No necesitamos dar la bienvenida a nuestros señores de androide a los señores.

¿Por qué es esto mejor que las redes neuronales actuales?

Todo el concepto del CTM básicamente se deshace de la idea de problemas de “un solo tiro”, que a menudo se ve como un unificado de oro con modelos de IA, donde necesita obtener la respuesta correcta la veterano parte del tiempo en el interior de la ventana fija que tiene que impulsar el problema a través de su red de transformadores, que es el tipo de red neuronal que alimenta el chatgpt, por ejemplo.

Esa es una de las razones por las que los LLM actuales verdaderamente no tienen una buena modo de corregir el porcentaje relativamente pequeño de veces que se equivocan. Ha habido mejoras con la sujeción de pensamiento, la autoprueba y rebotando poco entre dos modelos hasta que sea mejor, pero parece que el enfoque CTM podría cerrar una brecha importante en la precisión y la confiabilidad.

Basado en la promesa de Sakana contornos en sus documentos, esto podría significar combinar las fortalezas de modelos como LLM con la adaptabilidad y el crecimiento de los cerebros biológicos. Además creo que esto tiene implicaciones para la robótica, y ayudar a las máquinas encarnadas a estudiar, crecer y existir en el mundo físico más como nosotros.

Relacionado

¿Qué es la deslumbramiento de IA? ¿Puede el chatgpt delirar?

Los chatbots de IA pueden delirar. Esto es lo que eso significa para ti.

Las desventajas del pensamiento demasiado

El pensamiento continuo es poderoso, pero viene con compensaciones. Primero, los CTM son más complejos y hambrientos de posibles que las redes de viandas simple. Permitir que cada neurona lleve su historial expande el estado interno de la red masivamente. En la experiencia, la capacitación de un CTM puede exigir mucha más potencia y memoria de cálculo. Pueden tardar más en entrenar y pueden precisar más datos o iteraciones para converger. La inferencia todavía puede ser más lenta si el maniquí elige muchos pasos de pensamiento para una entrada difícil.

Encima, todas las herramientas y bibliotecas actuales se basan en modelos estáticos, no CTMS, por razones obvias. Entonces, si verdaderamente hay poco en esto, las herramientas tomarán algún tiempo para ponerse al día.

El otro gran problema es asaz obvio, ¿cuándo debería dejar de pensar? Existe el peligro de que “fugitivo” piense de dónde el CTM simplemente va en círculo. Por lo tanto, tiene que acaecer algunas reglas asaz sofisticadas para ayudarlo a entender cuándo está hecho. Si no lo hace, puede obtener la amplificación de error y el mismo tipo de alucinaciones que ya tenemos que el maniquí se aleja de la verdad del suelo con la que comenzó.

El extremo problema principal, y es un Biggie, es que este maniquí CTM temprano aún está muy allá de igualar los mejores modelos de transformadores actuales cuando se tráfico de precisión. Según un documentación de VentureBeat Se está quedando aceptablemente en los puntos de remisión de precisión en este momento.

Relacionado

¿Qué es un LLM? Cómo AI mantiene conversaciones

Los LLM son una tecnología increíblemente emocionante, pero ¿cómo funcionan?

Nuestras mentes siguen siendo un enigma

Mientras que lo que he conocido de CTMS hasta ahora basado en los documentos de Sakana Ai parece un parte Al igual que lo que vemos en los cerebros humanos, la verdad es que todavía no sabemos mucho sobre cómo funcionan nuestras propias mentes. Podría ser que los investigadores de IA se hayan tropezado con una decisión similar a lo que la selección natural ha creado para nosotros y otras especies animales, pero todavía podría ser que hayamos creado poco en una pista paralela que eventualmente podría ser igualmente capaz.

He sentido que los modelos actuales son solo una parte del rompecabezas de la IA más generalizada durante un tiempo, como un LLM es más como el centro de verbo de un cerebro que todo, y a primera instinto los CTM se parecen a otra parte del rompecabezas para mí. Así que seguiré el progreso de Sakana con gran interés.