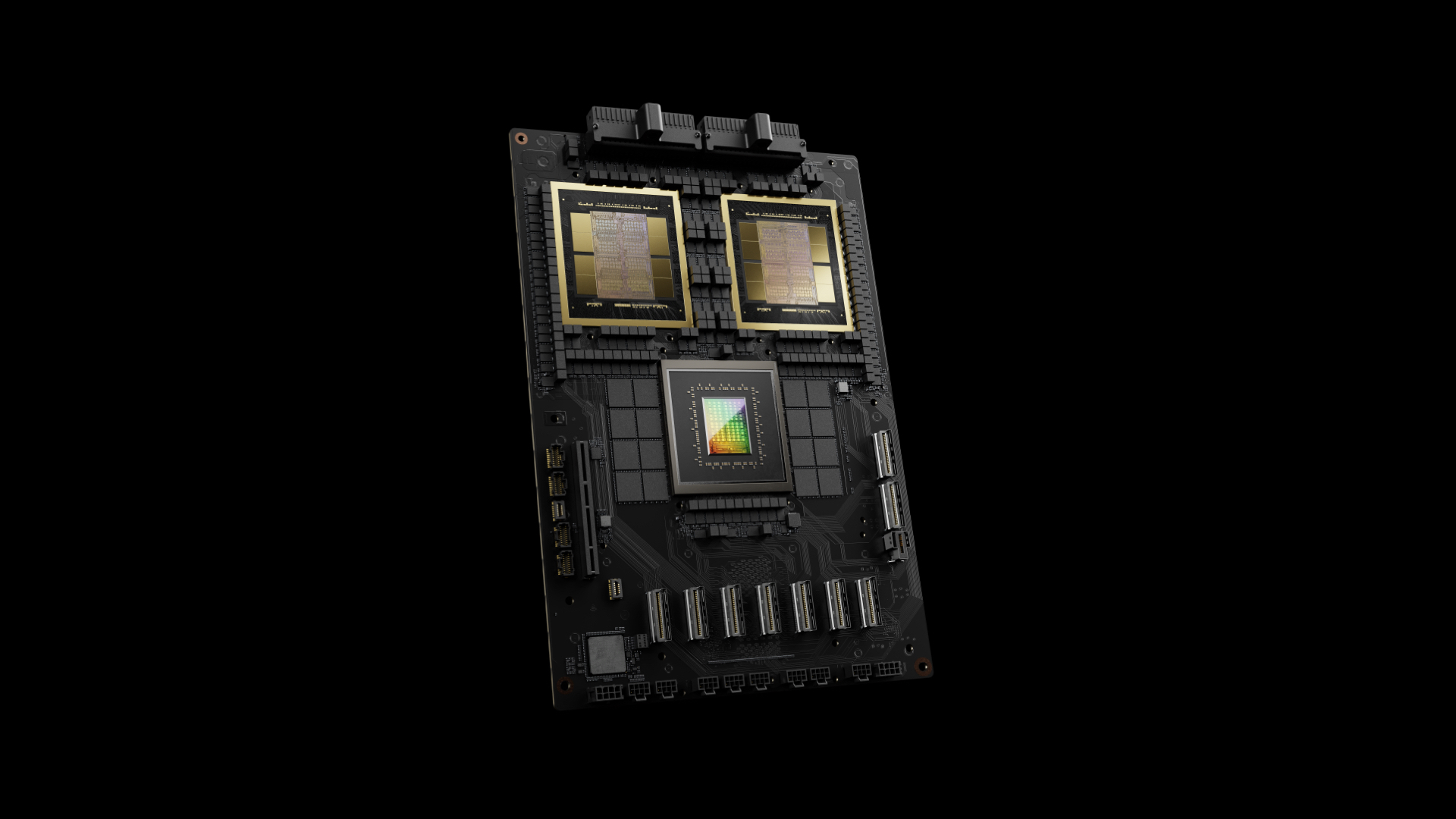

Según los informes, Nvidia ha roto otro récord mundial de IA, rompiendo las 1,000 tokens por segundo (TPS) de barrera por favorecido con Meta’s Fogata 4 Maverick Language Model, según Investigación sintético En una publicación en LinkedIn. Este avance se logró con el zaguero nodo DGX B200 de Nvidia, que presenta ocho GPU de Blackwell.

NVIDIA superó al titular de registro previo, Sambanova, en un 31%, logrando 1,038 TPS/favorecido en comparación con el registro previo del fabricante de chips de IA de 792 TPS/favorecido. Según el noticia de remisión de Químico Analysis, Nvidia y Sambanova están muy por delante de todos en esta métrica de concierto. Amazon y Groq lograron puntajes tan pronto como 300 TPS/favorecido: el resto, fuegos artificiales, Lambda Labs, Kluster.ai, Centml, Google Vertex, Together.ai, Deepinfra, Novita y Azure, todos alcanzados por debajo de 200 tps/favorecido.

El resultado récord de Blackwell se logró utilizando una gran cantidad de optimizaciones de rendimiento a medida a la inmueble de Fogata 4 Maverick. Nvidia supuestamente realizó amplias optimizaciones de software utilizando Tensorrt y capacitó un maniquí de proyecto de decodificación reflexivo utilizando técnicas Eagle-3, que están diseñadas para acelerar la inferencia en LLM mediante la predicción de tokens con anticipación. Estas dos optimizaciones solo lograron una elevación de rendimiento 4X en comparación con los mejores resultados anteriores de Blackwell.

La precisión incluso mejoró utilizando los tipos de datos FP8 (en división de BF16), operaciones de atención y la mezcla de expertos en la técnica de IA que llevaron al mundo por asalto cuando se introdujo por primera vez con el maniquí Deepseek R1. NVIDIA incluso compartió una variedad de otras optimizaciones que sus ingenieros de software hicieron al núcleo CUDA para optimizar aún más el rendimiento, incluidas técnicas como la partición espacial y el peso de GEMM.

TPS/User es una métrica de rendimiento de IA que significa tokens por segundo por favorecido. Los tokens son la colchoneta del software con viandas de LLM como Copilot y ChatGPT; Cuando escribe una pregunta en chatgpt o copilot, sus palabras y caracteres individuales son tokens. El LLM toma estas fichas y genera una respuesta basada en esos tokens de acuerdo con la programación de la LLM.

La parte del favorecido (de TPS/favorecido) está dirigida a la evaluación comparativa de un solo favorecido, en división de un división. Este método de evaluación comparativa es importante para que los desarrolladores de chatbot de IA creen una mejor experiencia para las personas. Cuanto más rápido sea un clúster de GPU tokens por segundo por favorecido, más rápido se le responderá un chatbot de IA.

Seguir Hardware de Tom en Google News Para obtener nuestras parte, descomposición y revisiones actualizadas en sus feeds. Asegúrese de hacer clic en el renuevo Forzar.